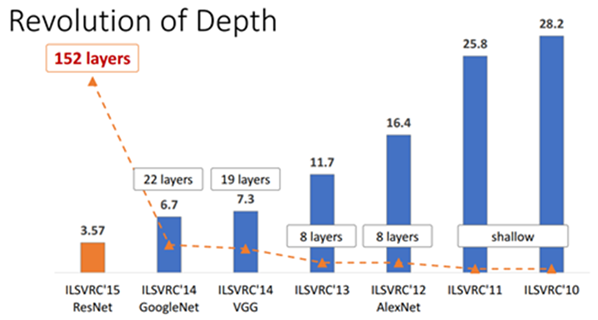

这是一张在人工智能领域,尤其是深度神经网络领域经常使用的图,表明在ILSVRC图像识别大赛中,不同年代的最佳算法的性能,以误差率的大小来表示,越小越好。ILSVRC(ImageNet Large Scale Visual Recognition Challenge)是近年来计算机视觉和图像识别领域最热门和最权威的挑战赛之一,代表了图像识别领域的最高水平,吸引了无数人工智能研究者的参与,影响力很大,可以说“引无数专家竞折腰”。

ImageNet数据集是ILSVRC竞赛使用的是数据集,由斯坦福大学华裔女科学家李飞飞教授等人发起,包含了超过1400万张全尺寸的有标记图片,包括2万多个类别。每年的ILSVRC比赛,组织者从ImageNet数据集中抽出部分样本给参赛方使用。以2012年为例,比赛的训练集包含1281167张图片,验证集包含50000张图片,测试集为100000张图片。

在上图中,我们可以清楚看到,2010年和2011年的最佳算法都采用的是浅层模型,误差分别为28.2%和25.8%。图像识别专家们经过1年的辛苦努力,才把误差降低了1.4%,实在是微不足道。2012年的AlexNet网络是个标志性事件。Hinton教授和他的学生Alex等人用8层深度神经网络AlexNet,将误差降低到16.4%。与前一年相比,误差比前一年降低了9.4%,下降非常明显。在此之后,各国科学家们在此网络的基础上不断改进,网络层数不断增加,优化技术也更加先进,图像识别误差逐步下降。

2015年,几个中国科学家发明了152层网络ResNet,居然将误差下降到3.57%,性能远超AlexNet, 夺得当年大赛的冠军。该网络的错误率率甚至低于人类专家,引起了广泛关注,也是我们华人人工智能研究的骄傲和标杆。此后的2017年,举办多年的ImageNet大赛停办了,因为在图像识别问题上,ResNet已经超过人类智能,并且也没有什么改进空间了。

2019年,美国计算机学会ACM评选图灵奖,没有将图灵奖发给发明性能最佳网络ResNet的几名中国科学家,而是把图灵奖颁发给了性能最差的深度神经网络AlexNet的发明人Hinton教授等人。这不经意间揭示了图灵奖的奥秘:尊重原创、重视首创、表彰开创。

首创也就是原创,未必是最佳,也未必是最优,但它一定是开创性的。我们人工智能研究工作绝大部分都是:1)证明图灵奖的思路是正确的,是能解决很多同类问题,2)改进图灵奖的思路,使得他们的性能更提高;3)拓展图灵奖的思路,使之应用更广泛。尽管很多研究成果的效果已经远胜于图灵奖当年的原创性论文,但就是离图灵奖越来越远。据说Hinton教授等人坚持搞深度神经网络,已经坐了30年的冷板凳,终于“守得云开见月明”,功夫不负有心人啊。真心希望我们有一批愿意坐冷板凳,做冷门问题和冷门方向的科学家。他们能“咬定青山不放松,立根原在破岩中”,直到把冷板凳做热,冷门变成热门,引领世界科技的发展。